-

大语言模型 编辑

大语言模型(Large Language Model, LLM)是自然语言处理(NLP)领域的一种先进技术,它基于深度学习,特别是基于Transformer结构的神经网络模型,旨在理解和生成人类语言文本。这些模型通过在大规模语料库上进行训练,学习到了丰富的语言知识和上下文理解能力,能够在多种NLP任务中展现出卓越的性能。

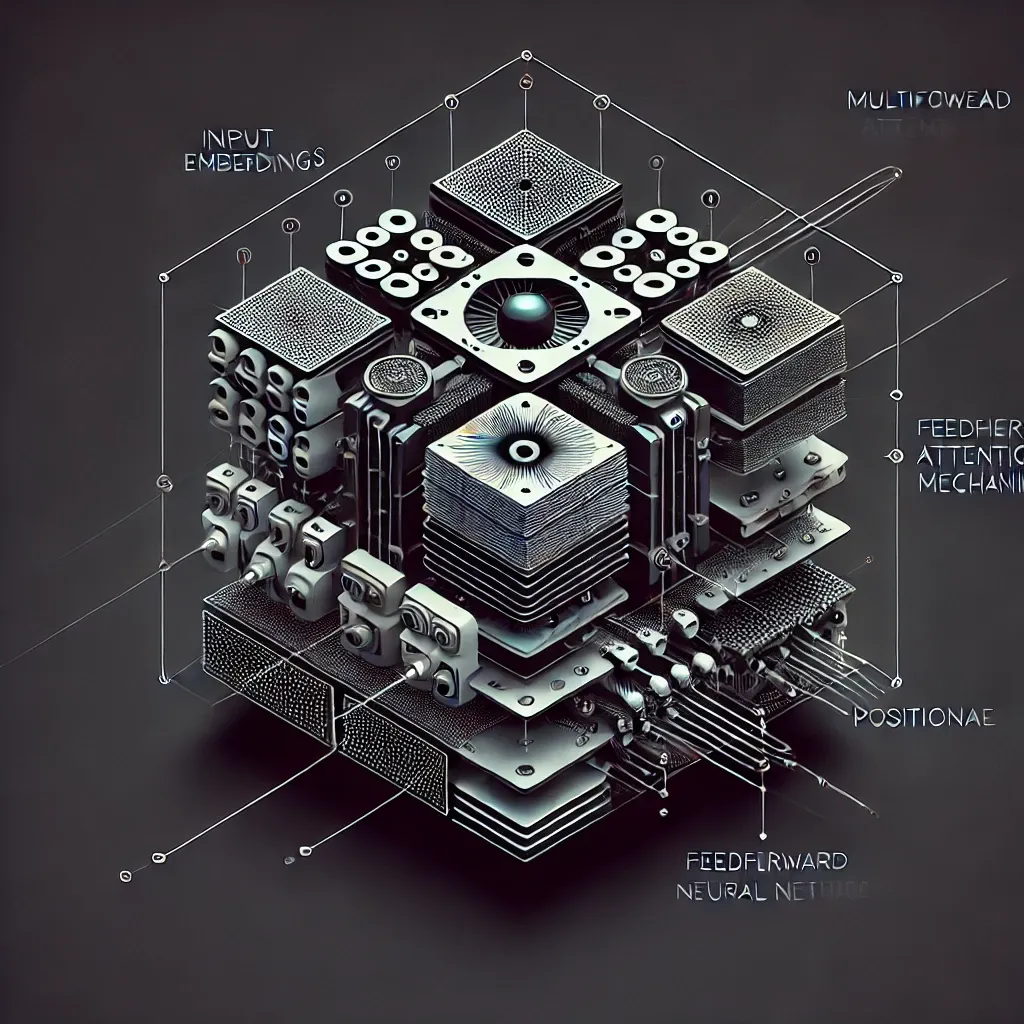

Transformer模型基础

Transformer模型是大语言模型的核心架构。与传统基于RNN(循环神经网络)或CNN(卷积神经网络)的模型不同,Transformer完全依赖自注意力(Self-Attention)机制来处理输入序列,这种机制使得模型能够同时处理序列中的所有元素,捕获更远的依赖关系,并显著提升训练速度和推理能力。

模型训练

大语言模型的训练涉及以下几个关键步骤:

数据收集:收集海量的文本数据,包括但不限于书籍、网页、社交媒体内容等,以构建训练语料库。

预处理:对收集到的数据进行清洗、分词、编码等预处理操作,以适应模型训练的需求。

模型训练:使用大规模并行计算资源,在高性能计算集群上训练模型,通过优化算法(如Adam)调整模型参数,以最小化损失函数(如交叉熵损失)。

大语言模型

大语言模型

自然语言生成

大语言模型能够生成连贯、流畅的文本,广泛应用于内容创作、摘要生成、对话系统等场景。例如,它们可以辅助作家创作小说、新闻稿,或生成产品描述等。

自然语言理解

在理解人类语言方面,大语言模型能够执行问答系统、情感分析、文本分类等任务。通过理解输入文本的含义和上下文,模型能够准确回答用户问题、判断文本情感倾向或进行主题分类。

代码理解与生成

随着技术的进步,一些大语言模型还被应用于代码理解与生成领域,能够自动编写程序代码、修正编程错误、甚至进行代码补全,极大地提高了软件开发效率。

计算资源与能耗

大语言模型的训练需要庞大的计算资源和能源消耗,这对环境造成了不小的压力。未来,研究将致力于开发更高效的算法和硬件,以降低训练成本和环境影响。

智能化与可解释性

随着技术的不断进步,大语言模型将朝着更加智能化的方向发展,能够更好地理解人类意图和上下文。同时,提高模型的可解释性,使人类能够理解其决策背后的原因和逻辑,也将成为未来研究的重要方向。

大语言模型作为人工智能领域的一项重要技术,正不断推动着自然语言处理及相关领域的进步,为人类带来更加便捷、智能的交互体验。

模型规模的持续增长

近年来,大语言模型的规模持续扩大,从最初的几亿参数发展到如今的数百亿甚至数千亿参数。这种规模的增长不仅提升了模型的性能,还使得模型能够处理更加复杂和抽象的语言任务。然而,这也带来了训练难度和计算成本的增加,促使研究人员探索更高效的训练方法和硬件加速技术。

多模态融合

随着技术的进一步发展,大语言模型开始与计算机视觉、语音识别等其他模态的模型进行融合,形成了多模态大模型。这些模型能够同时处理文本、图像、音频等多种类型的数据,实现更加全面和深入的理解与生成。例如,通过结合图像信息和文本描述,模型可以生成更加生动和形象的描述性文本。

少样本学习与无监督学习

为了降低模型对大量标注数据的依赖,研究人员开始探索少样本学习(Few-Shot Learning)和无监督学习(Unsupervised Learning)在大语言模型中的应用。少样本学习允许模型在仅有少量标注数据的情况下进行快速适应和泛化;而无监督学习则利用未标注的海量数据进行自我学习和知识发现。这些技术有望进一步提升大语言模型的灵活性和泛化能力。

就业市场的变革

大语言模型的广泛应用对就业市场产生了深远影响。一方面,它们提高了工作效率和生产力,创造了新的就业机会;另一方面,它们也可能替代一些传统职业,导致部分岗位的消失。因此,社会需要关注这一变革趋势,加强职业教育和培训,帮助人们适应新的就业环境。

隐私与数据保护

大语言模型的训练需要大量的个人数据,这引发了关于隐私和数据保护的担忧。如何确保数据在收集、处理和存储过程中的安全性和合规性,防止数据泄露和滥用,是亟待解决的问题。同时,也需要建立更加完善的法律法规体系来规范数据的使用和保护。

公平性与包容性

大语言模型在生成文本时可能受到训练数据中偏见的影响,导致生成结果的不公平性和歧视性。为了确保模型的公平性和包容性,研究人员需要在模型设计、训练数据选择和评估标准等方面采取相应措施,减少偏见和歧视的发生。同时,也需要加强公众对模型输出结果的审视和批判性思维能力的培养。

1、本站所有文本、信息、视频文件等,仅代表本站观点或作者本人观点,请网友谨慎参考使用。

2、本站信息均为作者提供和网友推荐收集整理而来,仅供学习和研究使用。

3、对任何由于使用本站内容而引起的诉讼、纠纷,本站不承担任何责任。

4、如有侵犯你版权的,请来信(邮箱:baike52199@gmail.com)指出,核实后,本站将立即删除。

下一篇 随机并行梯度下降算法

上一篇 生活教育